Anastasia Dönau

Online-Marketing & Redaktion

18.08.2025

-10 Minuten

-Google Indexierung

Inhaltsverzeichnis

- Google Indexierung – So landet deine Webseite in den Suchergebnissen

- Das Wichtigste vorab

- Was ist die Google Indexierung und wie funktioniert sie?

- Der Googlebot (Crawler)

- Prüfen, ob eine Website im Google Index ist

- Indexierung beschleunigen

- Faktoren, die die Indexierung beeinflussen

- Gründe, warum eine Seite nicht von Google indexiert wird

- Indexierung gezielt verhindern oder einschränken

- Dauer der Indexierung

- Bedeutung für die Suchmaschinenoptimierung (SEO)

- Online-Marketing mit Ambitive – Wir wissen wie Google funktioniert

- FAQ

Google Indexierung – So landet deine Webseite in den Suchergebnissen

Im digitalen Wettbewerb entscheidet die Sichtbarkeit in den Suchmaschinen über Erfolg oder Misserfolg. Wer mit seiner Website bei Google gefunden werden will, muss dafür sorgen, dass die eigenen Inhalte im Google-Index landen. Doch wie genau funktioniert dieser Prozess eigentlich, was prüft Google dabei und wie kannst du aktiv darauf Einfluss nehmen?

In diesem Artikel erfährst du, wie die Google Indexierung abläuft, welche Faktoren eine Rolle spielen und wie du typische Fehler vermeidest. Außerdem geben wir dir konkrete Tipps und Best Practices an die Hand, mit denen du die Indexierung deiner Seite beschleunigen und sicherstellen kannst.

Das Wichtigste vorab

- Der Google-Index ist die Datenbank, in der Google alle Webseiten speichert, die die Suchmaschine im Internet gefunden hat.

- Nur Webseiten, die sich im Google-Index befinden, können in den Suchergebnissen von Google erscheinen.

- Die Indexierung kann Tage oder Wochen dauern, abhängig von verschiedenen Faktoren.

Was ist die Google Indexierung und wie funktioniert sie?

Der Google Index ist eine riesige Datenbank (Verzeichnis) mit allen Webseiten, die der Crawler einer Suchmaschine im gesamten Web gefunden und gespeichert hat. So kann Google Suchanfragen verarbeiten und passende Suchergebnisse anzeigen.

Unter Google Indexierung versteht man den Prozess, bei dem der Googlebot die Inhalte einer Website analysiert, versteht und verarbeitet. Liegen hierbei keine Probleme vor, wird die Website in der Datenbank gespeichert. Nach erfolgreicher Indexierung kann die Seite in den organischen Suchergebnissen erscheinen und wird ins Ranking einbezogen.

Der Googlebot (Crawler)

Googlebot ist der Name für die Webcrawler-Software von Google. Auch bekannt als Spider durchsucht der Crawler automatisch das Internet, um neue oder aktualisierte Webseiten für die Google Suche zu entdecken und diese in den Index zu übertragen. Es gibt zwei Arten von Googlebots:

- Googlebot für Smartphones: Dieser simuliert einen Nutzer mit einem Mobilgerät und ist für das Crawling mobiler Versionen von Websites verantwortlich. Da Google für die meisten Websites primär die mobile Version indexiert, erfolgen die meisten Anfragen über diesen Crawler.

- Googlebot für Computer: Dieses Tool simuliert einen Nutzer mit einem Computer und crawlt die Desktop-Version von Webseiten.

Wie der Googlebot arbeitet

1. Crawling (Durchsuchen)

Der Googlebot startet mit einer Liste von URLs, die er bereits kennt und folgt dann den Hyperlinks auf diesen Seiten, um neue und aktualisierte Inhalte im Web zu entdecken. Dieser Prozess ist vergleichbar mit einer Spinne, die sich in ihrem Netz bewegt. Daher stammt der Name „Spider“.

Der Googlebot besucht täglich Milliarden von Seiten, um sicherzustellen, dass der Index von Google stets so aktuell wie möglich ist.

Dabei berücksichtigt er zusätzlich die robots.txt-Datei einer Website, die es Webmastern ermöglicht, bestimmte Bereiche ihrer Website vom Crawling auszuschließen.

2. Rendering (Wiedergabe)

Sobald der Googlebot eine Seite entdeckt hat, lädt er deren Inhalt herunter und rendert die Seite. Das bedeutet, er verarbeitet die Seite so, wie ein moderner Webbrowser sie anzeigen würde, einschließlich JavaScript und CSS. Dies ist essenziell, da viele Websites dynamische Inhalte verwenden, die erst durch JavaScript geladen werden. Durch das Rendering kann der Googlebot den Inhalt einer Seite so sehen, wie ein Nutzer sie sehen würde.

3. Indexierung

Nach dem Crawling und Rendering analysiert der Googlebot die gesammelten Informationen über die besuchte Website. Das sind unter anderem Text, Keywords, Seitenstruktur, Bilder, Videos, Links, Dateien und Meta-Tags. Jene Daten werden anschließend im Google-Index gespeichert.

Dein Content rankt nicht? In unserem Artikel „SEO-Texte schreiben – Mit 12 Tipps zu besserem Content und höheren Rankings“ erfährst du, wie man Texte schreibt, die Google lieben wird.

4. Aktualisierung

Der Googlebot besucht Webseiten regelmäßig erneut, um Änderungen oder neue Inhalte zu erkennen. Die Häufigkeit der Besuche (auch Crawl-Budget genannt) hängt von verschiedenen Faktoren ab, wie zum Beispiel der Aktualisierungsfrequenz der Website, der Anzahl der externen Links, die auf die Seite verweisen und der allgemeinen Qualität der Website.

Mobile-First-Indexierung

2016 begann Google mit dem Projekt, primär die mobilen Versionen von Webseiten zu crawlen, zu indexieren und für das Ranking zu berücksichtigen. Das ist vor allem darauf zurückzuführen, dass die meisten Nutzer heutzutage über mobile Geräte auf das Internet zugreifen. Rund 60 % aller Suchanfragen auf Google erfolgen über ein mobiles Gerät und 61 % der User sind eher bereit, einen Kauf zu tätigen, wenn die Seite mobil optimiert ist.

Wird für die Erstellung der Website nicht auf Responsive Webdesign oder eine separate mobile Seitenversion gesetzt, hat dies schlechtere Rankings zur Folge.

Du suchst professionelle Unterstützung?

Maßgeschneiderte Lösungen für Website, SEO, Google Ads und Hosting - Jetzt unverbindlich anfragen.

Schreib unsPrüfen, ob eine Website im Google Index ist

Die regelmäßige Überwachung des Indexierungsstatus der Seiten einer Website ist eine der wichtigsten Grundlagen einer erfolgreichen SEO-Strategie.

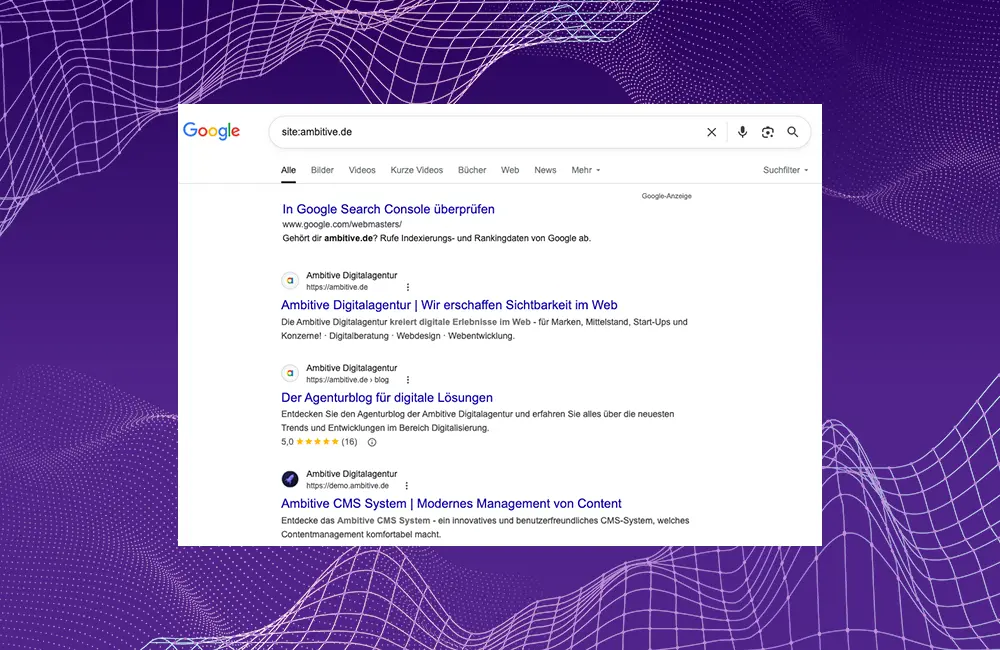

Site-Abfrage in der Google Suche

Die Methodik Site-Abfrage eignet sich besonders gut für einen schnellen Check einzelner URLs:

Gib hierfür Folgendes in die Suchmaske ein: site:deinewebsite.de/unterseite

Ersetze „deinewebsite.de/unterseite“ durch die jeweilige URL, die du überprüfen möchtest. Achte darauf, den Link ohne https:// oder www einzugeben.

Wird deine Seite nun in den Suchergebnissen angezeigt, bedeutet dies, dass der Crawler sie gefunden hat und sie schließlich indexiert wurde. Bleibt die Ergebnisseite leer, konnte deine Seite nicht aufgefunden werden oder wurde vorsätzlich aus dem Index ausgeschlossen.

Alternativ kannst du Folgendes in die Google Suchleiste eingeben: site:deinewebsite.de

Nun erhältst du eine Übersicht aller URLs deiner Website, die sich im Google Index befinden.

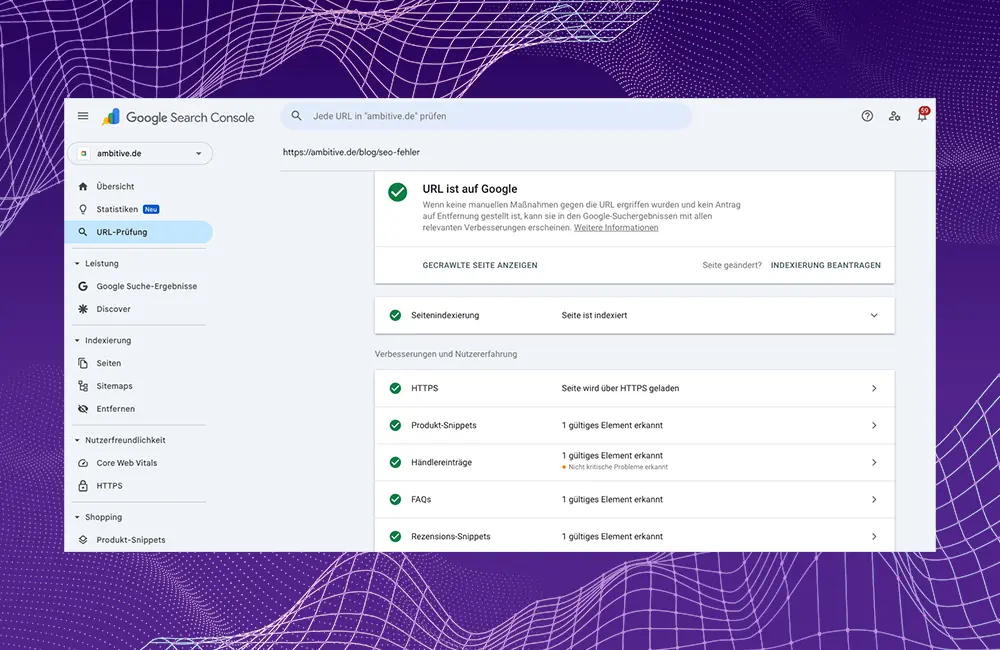

Überprüfung in der Google Search Console (URL-Prüftool)

Die Google Search Console ist ein kostenloses Tool von Google. Hier können Websitebetreiber die Leistung ihrer Seite in den Google-Suchergebnissen überwachen und mit Empfehlungen optimieren. Es bietet Einblicke in Suchanfragen, Klicks, Impressionen und die Platzierung der Website.

Zur Einrichtung der Search Console musst du dich mit deinem Google-Konto anmelden und anschließend eine Property (Website oder App) hinzufügen. Bestätige die Inhaberschaft über die Property durch das Hochladen einer HTML-Datei, das Hinzufügen eine DNS-Eintrags oder das Verbinden mit Google Analytics oder dem Google Tag Manager.

Über das URL-Prüftool in der Search Console erhältst du detaillierte Informationen darüber, wie Google eine bestimmte URL auf deiner Website wahrnimmt. Du kannst so diagnostizieren, warum eine Seite möglicherweise nicht indexiert wird, nachsehen, wann Google eine Seite zuletzt gecrawlt hat, den Status einer bereits indexierten Seite überprüfen (Sichtbarkeit) sowie die Indexierung beantragen.

- Zugriff auf das Tool: Gebe die vollständige URL, die du prüfen möchtest, in die Suchleiste am oberen Rand eines beliebigen Search Console-Bildschirms ein.

- Abrufen von Indexinformationen: Nachdem du eine URL eingegeben hast, zeigt das Tool Daten direkt aus dem Google-Index an. Du siehst unter anderem: ob die URL im Index ist („URL ist auf Google“), das Datum des letzten Crawlings, Informationen zu gefundenen Rich Results, die von Google ausgewählte kanonische URL und potenzielle Probleme.

- Live-Test durchführen: Wenn Sie Änderungen vorgenommen haben oder wenn es sich um eine neue Seite handelt, kannst du über das URL-Prüftool die Indexierung beantragen. Dies signalisiert Google, dass die Seite erneut gecrawlt und in den Index aufgenommen werden sollte. Beachte, dass für einzelne URL-Einreichungen ein Kontingent gilt und mehrmalige Anfragen für dieselbe URL das Crawling nicht beschleunigen.

Alternativ kannst du in der Google Search Console eine komplette Sitemap hochladen, um für mehrere URLs gleichzeitig die Indexierung zu beantragen. Die Sitemap-Dateien müssen in der robots.txt referenziert werden, damit Google sie findet.

Indexierung beschleunigen

Durch eine Beantragung der Indexierung in der Google Search Console kann der Google Crawler angestoßen und der Prozess beschleunigt werden. Allerdings macht dies Google lediglich darauf aufmerksam, dass geänderte oder neue Inhalte vorliegen. Der Googlebot benötigt dennoch Zeit für die Ausführung.

Du suchst professionelle Unterstützung?

Maßgeschneiderte Lösungen für Website, SEO, Google Ads und Hosting - Jetzt unverbindlich anfragen.

Schreib unsFaktoren, die die Indexierung beeinflussen

Die Indexierung einer Webseite durch Google ist ein komplexer Prozess, der von einer Vielzahl von Faktoren beeinflusst wird. Diese Gesichtspunkte lassen sich grob in die 3 Kategorien technische Aspekte, Inhalte und die allgemeine Autorität einer Website unterteilen:

Technische Faktoren

robots.txt: Diese Datei weist Suchmaschinen an, welche Bereiche einer Website gecrawlt werden dürfen und welche nicht. Wenn wichtige Seiten hier gesperrt sind, können sie nicht indexiert werden. Vorsicht: Eine Sperrung per robots.txt verhindert nur das Crawling, nicht unbedingt die Indexierung, insbesondere wenn die Seite viele Backlinks aufweist.

noindex Meta-Tags: Dieses Tag im HTML-Header einer Seite () weist Suchmaschinen explizit an, die Seite nicht in den Index aufzunehmen.

Canonical-Tags: Wenn eine Website duplizierte Inhalte (Duplicate Content) auf verschiedenen URLs hat, hilft das Canonical-Tag () Google zu verstehen, welche Version die bevorzugte Seite ist und im Ranking auftauchen soll.

Serverfehler (HTTP-Statuscodes): Seiten, die einen 4xx (Client-Fehler, z. B. 404 Not Found) oder 5xx (Server-Fehler) Statuscode zurückgeben, können nicht gecrawlt oder indexiert werden.

Website-Geschwindigkeit: Langsame Ladezeiten können das Crawl-Budget einer Website reduzieren und die Indexierung neuer oder aktualisierter Seiten verzögern. Google priorisiert schnelle Seiten.

URL-Struktur: Eine klare, logische und sprechende URL-Struktur hilft Google, die Hierarchie und den Inhalt einer Seite besser zu verstehen.

Sitemaps (XML-Sitemap): Eine XML-Sitemap ist eine Liste aller wichtigen Seiten einer Website. Die Datei kann Google über die Search Console zur Verfügung gestellt werden. Sie hilft der Suchmaschine, neue Seiten schneller zu entdecken und zu indexieren, insbesondere bei großen Websites oder solchen mit vielen nicht direkt verlinkten Seiten. Sitemaps beschleunigen die Indexierung, sind aber keine Garantie dafür, dass alle gelisteten Seiten indexiert werden.

Interne Verlinkung: Eine optimale interne Verlinkung stellt sicher, dass der Googlebot alle relevanten Seiten finden kann, indem er den Links folgt. Neue Inhalte, die von der Startseite oder anderen wichtigen Seiten verlinkt werden, werden in der Regel schneller entdeckt.

JavaScript-Rendering: Da viele moderne Websites stark auf JavaScript basieren, muss der Googlebot in der Lage sein, JavaScript auszuführen und die Inhalte korrekt zu rendern, um sie zu sehen und zu indexieren.

Inhaltsbezogene Faktoren

Einzigartigkeit und Originalität: Duplicate Content innerhalb der eigenen Website oder von anderen Websites kann die Indexierung beeinträchtigen. Google möchte einzigartigen und wertvollen Inhalt im Index haben.

Inhaltliche Tiefe und Vollständigkeit: „Thin Content“ (sehr dünne Inhalte) oder Seiten mit geringem Informationsgehalt sind weniger wahrscheinlich, gut zu ranken oder überhaupt indexiert zu werden.

Aktualität des Inhalts: Regelmäßige Aktualisierungen und neue, relevante Inhalte signalisieren Google, dass die Website aktiv ist und einen Mehrwert bietet, was die Crawling-Frequenz erhöhen kann.

Nutzerintention erfüllen: Inhalte, die die Suchintention der Nutzer optimal erfüllen, werden von Google bevorzugt.

E-E-A-T: Obwohl Google Experience, Expertise, Authoritativeness und Trustworthiness nicht als direkten Ranking-Faktor definiert, ist E-E-A-T ein wichtiges Konzept für die Bewertung der Qualität von Inhalten, insbesondere in sensiblen Bereichen (YMYL – Your Money Your Life). Content von erfahrenen, kompetenten, autoritativen und vertrauenswürdigen Quellen wird höher eingestuft.

Multimedia-Inhalte: Bilder, Videos und andere Medien, die gut optimiert (Alt-Text, geringe Dateigröße, WebP-Format) sind, können ebenfalls zur Indexierung beitragen.

Relevante Keywords: Die Verwendung relevanter Keywords im Text, in Überschriften und in Meta-Informationen hilft Google, den thematischen Kontext einer Seite zu verstehen.

Natürliche Sprachverwendung: Übermäßiges Keyword-Stuffing (häufiges Wiederholen von Keywords) kann als Spam wahrgenommen werden und die Indexierung negativ beeinflussen.

Website-Autorität und externe Faktoren

Anzahl und Qualität der Backlinks: Externe Links von hochwertigen und relevanten Websites sind ein starkes Signal für Google, dass eine Seite wichtig und vertrauenswürdig ist. Sie helfen Google, neue Seiten zu entdecken und die Relevanz der Seite zu beurteilen.

Mobile-Freundlichkeit: Google hat auf Mobile-First-Indexing umgestellt, was bedeutet, dass primär die mobile Version einer Website für das Crawling und die Indexierung herangezogen wird. Eine mobilfreundliche Website ist daher das A und O für die Indexierung und Rankings.

Core Web Vitals: Hierbei handelt es sich um Metriken, die die Benutzerfreundlichkeit einer Website messen (Ladeleistung, Interaktivität, visuelle Stabilität). Eine gute Page Experience kann die Indexierung und das Ranking positiv beeinflussen.

Gründe, warum eine Seite nicht von Google indexiert wird

Technische Gründe

noindex Meta-Tag oder HTTP-Header

Problem: Im head-Bereich der Seite befindet sich ein noindex-Tag oder der Server sendet einen X-Robots-Tag: noindex HTTP-Header. Beides weist Google an, die Seite nicht in den Index aufzunehmen.

Lösung: Entferne den noindex-Befehl, wenn die Seite indexiert werden soll. Überprüfe dies mit dem URL-Prüftool in der Search Console.

robots.txt Datei blockiert das Crawling

Problem: Die robots.txt-Datei weist den Googlebot an, bestimmte Seiten oder Verzeichnisse nicht zu crawlen. Ist eine Seite blockiert, kann Google ihren Inhalt nicht lesen und somit auch nicht indexieren.

Lösung: Bearbeite die robots.txt, um das Crawling der betroffenen Seite zu erlauben. Beachte, dass eine blockierte Seite trotzdem im Index erscheinen kann, wenn sie viele Backlinks aufweist. Allerdings kann Google in diesem Fall den Inhalt nicht bewerten.

Fehlerhafter Statuscode

Problem: Die Seite gibt einen Fehlerstatuscode zurück (z.B. 404 Not Found, 403 Forbidden, 500 Internal Server Error, 503 Service Unavailable).

Lösung: Behebe die Serverprobleme oder stelle sicher, dass die Seite korrekt geladen wird und einen 200 OK Statuscode zurückgibt. Überprüfe dies in der Search Console oder mit einem Online-HTTP-Statuscode-Checker.

Ladezeitprobleme oder Timeout

Problem: Die Seite lädt zu langsam oder es kommt zu einem Timeout, bevor der Googlebot den Inhalt vollständig abrufen kann.

Lösung: Optimiere die Ladezeit der Seite (Bilder komprimieren, Caching nutzen, unnötiges JavaScript/CSS entfernen).

Mehr über die Bedeutung der Core Web Vitals für SEO findest du in unserem ausführlichen Artikel.

Probleme mit der internen Verlinkung

Problem: Die Seite ist nicht von anderen Seiten deiner Website verlinkt oder nur von sehr wenigen, tief vergrabenen Seiten. Google hat Schwierigkeiten, diese zu entdecken.

Lösung: Sorge für eine logische und robuste interne Verlinkungsstruktur. Verlinke wichtige Seiten von deiner Startseite oder relevanten Unterseiten.

Keine oder fehlerhafte XML-Sitemap

Problem: Die Seite ist nicht in der eingereichten XML-Sitemap enthalten oder die Sitemap hat Fehler, sodass Google nicht über die Existenz der Website informiert wird.

Lösung: Stelle sicher, dass alle relevanten Seiten in deiner XML-Sitemap enthalten sind und dass die Sitemap fehlerfrei ist. Reiche sie anschließend in der Google Search Console ein.

Fehlende oder falsche Canonical-Tags

Problem: Wenn das kanonische Tag einer Seite auf eine andere URL verweist, signalisierst du Google, dass die andere URL die bevorzugte Version ist und indexiert werden sollte.

Lösung: Überprüfe, ob das Canonical-Tag auf die korrekte Version der Website verweist.

Fehlende Index-Berechtigung

Problem: Die Seite ist durch ein Login, eine Paywall oder andere Authentifizierungsmechanismen geschützt, sodass Google keinen Zugriff hat.

Lösung: Entferne die Zugriffsbeschränkung, wenn die Seite öffentlich sein soll.

Inhalts- und Qualitätsbezogene Gründe

Dünner Inhalt („Thin Content“)

Problem: Die Seite verfügt über sehr wenig Text, wenig nützliche Informationen oder ist nur eine Ansammlung von Keywords ohne echten Mehrwert. Google indexiert tendenziell keine Seiten mit geringer Qualität.

Lösung: Erweitere den Inhalt. Mach ihn informativer, relevanter und nützlicher für den Nutzer.

Duplizierter Inhalt

Problem: Die Seite hat den gleichen oder einen ähnlichen Inhalt wie eine andere Seite auf deiner Webseite oder eine externe Seite. Google indexiert in der Regel nur eine Version von doppeltem Inhalt.

Lösung: Verwende Canonical-Tags, um die bevorzugte Version zu kennzeichnen. Entferne doppelten Inhalt oder schreibe ihn um, um ihn einzigartig zu machen.

Geringe Qualität oder Spam

Problem: Die Seite wird von Google als minderwertig, spammy oder als Verstoß gegen die Qualitätsrichtlinien eingestuft (z.B. Keyword-Stuffing, versteckter Text, Cloaking).

Lösung: Bereinige die Seite von allen Spam-Praktiken und stelle sicher, dass sie einen hohen Mehrwert bietet.

Anderweitige Gründe

Neue Seite, noch nicht entdeckt

Problem: Die Seite ist sehr neu und Google hat sie noch nicht gefunden oder konnte sie noch nicht crawlen und indexieren.

Lösung: Reiche die Sitemap in der Google Search Console ein. Verwende das URL-Prüftool, um eine Indexierung anzufordern. Sorge für eine gute interne Verlinkung.

Manuelle Maßnahmen (Google Penalty)

Problem: Deine Website wurde manuell von Google abgestraft, da sie gegen die Richtlinien verstoßen hat. Dies kann dazu führen, dass einzelne Seiten oder die gesamte Website aus dem Index ausgeschlossen werden.

Lösung: Verzichte auf Black Hat SEO Maßnahmen. Behebe die in der Search Console gemeldeten Probleme.

Geringe Autorität der Website

Problem: Wenn eine Website insgesamt eine sehr geringe Autorität aufweist und nur wenige oder keine hochwertigen Backlinks auf die Seite verweisen, kann es länger dauern oder schwieriger sein, dass die Seite gecrawlt und indexiert wird, insbesondere wenn es viele andere, ähnliche Inhalte gibt.

Lösung: Arbeite am allgemeinen Linkaufbau und der E-E-A-T-Stärkung deiner Website.

Mehr dazu liest du in unserem Artikel über die häufigsten SEO-Fehler.

Indexierung gezielt verhindern oder einschränken

noindex-Meta-Tag: Füge in den Bereich deiner Seite ein. So wird Google explizit angewiesen, die Seite nicht zu indexieren, nachdem sie gecrawlt wurde.

X-Robots-Tag im HTTP-Header: Sende diesen Header serverseitig. Das ist ideal für Nicht-HTML-Dateien (z.B. PDFs) oder zur Steuerung ganzer Verzeichnisse.

robots.txt-Datei: Dies weist Suchmaschinen an, bestimmte Bereiche deiner Website nicht zu crawlen. Beachte, dass die Indexierung nicht unbedingt verhindert wird, wenn externe Links auf die Seite verweisen.

Du suchst professionelle Unterstützung?

Maßgeschneiderte Lösungen für Website, SEO, Google Ads und Hosting - Jetzt unverbindlich anfragen.

Schreib unsDauer der Indexierung

Die Indexierung erfolgt nicht sofort, nachdem eine neue Seite oder Änderungen an einer bestehenden Webseite veröffentlicht wurden. Wie lange die Indexierung dauert, kann nicht genau gesagt werden, da dies von verschiedenen Faktoren abhängt. In der Regel muss man mit einigen Tagen bis Wochen rechnen. Unter optimalen Bedingungen kann die Seite allerdings bereits nach wenigen Stunden im Google Index landen.

Bedeutung für die Suchmaschinenoptimierung (SEO)

Die Indexierung ist die absolute Grundlage der Suchmaschinenoptimierung und entscheidend für die Online-Sichtbarkeit einer Website. Im Grunde bedeutet die Indexierung, dass Google die Inhalte einer Website entdeckt, versteht und in seinen riesigen Datenkatalog aufnimmt.

Ist eine Seite nicht indexiert, existiert sie für die Google-Suche nicht. Das bedeutet wiederum, dass kein organischer Traffic auf die Website gelangt. Alle Online-Marketing Bemühungen in den Bereichen Content-Erstellung, technische Optimierung oder Linkaufbau sind nutzlos, wenn die Seiten nicht von Google erfasst werden.

Best Practices für die Google Indexierung

Online-Marketing mit Ambitive – Wir wissen wie Google funktioniert

Ob SEO oder SEA – wir sorgen dafür, dass dein Unternehmen online sichtbar wird und deine Zielgruppe genau dort erreicht wird, wo sie sucht. Vertraue auf unsere Erfahrung und praxisnahe Strategien, die Ergebnisse liefern.

Jetzt kostenloses Erstgespräch anfordern und online durchstarten!

FAQ

Wie funktioniert die Google Indexierung?

Google Indexierung ist der Prozess, bei dem der Googlebot (Googles Webcrawler) Webseiten entdeckt, ihren Inhalt analysiert und diese Informationen in Googles Datenbank speichert. Ist eine Seite im Index, kann sie bei relevanten Suchanfragen in den Ergebnissen erscheinen.

Warum indexiert Google meine Seite nicht?

Häufige Gründe dafür sind, dass die Seite ein noindex-Tag hat oder die robots.txt blockiert ist, technische Fehler vorliegen, der Inhalt von geringer Qualität ist oder die Seite einfach noch nicht von Google entdeckt wurde.

Wie finde ich heraus, ob eine Seite bei Google indexiert ist?

Am besten nutzt du das URL-Prüftool in der Google Search Console. Dort kannst du die spezifische URL eingeben und erhältst detaillierte Informationen zum Indexierungsstatus sowie mögliche Probleme. Alternativ kannst du site:deinewebsite.de/unterseite direkt in die Google-Suche eingeben.